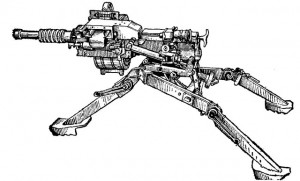

В связи с последними событиями (как-будто, новый АГС придумали, но циферки просто кончились – реальные АГС – только АГС-17 и АГС-30), а именно новой волной выпадания сайтов из индекса Яндекса, хочу поделиться правильными (на мой взгляд ![]() ) файлами robots.txt для DLE и WordPress.

) файлами robots.txt для DLE и WordPress.

Если раньше robots.txt я использовал, в основном, только для указания директивы hosts (чуть позже, когда наклепал много сайтов на ДЛЕ, начал ещё раздел user закрывать от индексации, так как много спам ссылок в профилях было), то теперь, волей-неволей, приходиться работать с этим файлом более плотно, во избежании вылета сайта из индекса.

Не в тему: решил проверить, как правильно писать волей-неволей, задал всезнающему Яндексу такой запрос, и на четвертой и пятой позиции оказалось видео. Первый раз такое увидел, удивился даже

.

Теперь же ситуация изменилась в корне – сейчас необходимо на новом (относительно новом) сайте закрыть все дубли контента от индексации. Дубли контента появляются в следующих случаях:

- Использование тегов (меток) на сайте

- Использование календаря, архивов материалов

- В WordPress ещё и использование категорий, но это спорный вопрос

Что избежать дублирование контента, не нужные нам разделы нужно закрыть от индексации инструкцией в файле robots.txt. Мой robots.txt для DLE (сегодня на 10+ сайтах менял, устал аж ![]() ):

):

User-agent: *

Disallow: /user/

Disallow: */rss.xml

Disallow: /tags/

Disallow: /2009/

Disallow: /2010/User-agent: Yandex

Host: site.ru

Disallow: /user/

Disallow: */rss.xml

Disallow: /tags/

Disallow: /2009/

Disallow: /2010/

user – профили пользователей, минимум оригинальной информации – максимум спама, в топку.

rss.xml – это из-за ошибок в панели вебмастера (формат документа не поддерживается), всё равно в индекс не возьмут, в топку.

tags – злобные теги, все беды из-за них, туда же.

2009-2010 – архивы новостей, календарь, лишнее дублирование контента, закрываем от индексации.

Мой robots.txt для WordPress:

User-agent: *

Disallow: /wp-admin

Disallow: /wp-includes

Disallow: /wp-content/plugins

Disallow: /wp-content/cache

Disallow: /wp-content/themes

Disallow: /trackback

Disallow: /feed

Disallow: /comments

Disallow: */trackback

Disallow: */feed

Disallow: */comments

Disallow: /tag

Disallow: /clickheat/

Disallow: */comment-page-*

Disallow: /xmlrpc.php

Disallow: /20*

Disallow: */*?replytocom*User-agent: Yandex

Disallow: /wp-admin

Disallow: /wp-includes

Disallow: /wp-content/plugins

Disallow: /wp-content/cache

Disallow: /wp-content/themes

Disallow: /trackback

Disallow: /feed

Disallow: /comments

Disallow: */trackback

Disallow: */feed

Disallow: */comments

Disallow: /tag

Disallow: /clickheat/

Disallow: */comment-page-*

Disallow: /xmlrpc.php

Disallow: /20*

Disallow: */*?replytocom*

Host: antonblog.ru

Используется на этом блоге, не для всех WordPress блогов хорошо. Как видно, я не стал закрывать от индексации категории, вместо этого я пользуюсь wordpress тегом <!–more–>. И какой то не правильной мне кажется идея закрытия категорий от индексации – тогда до старых постов как добираться поисковикам? Только по постраничной навигации? Это в скольких кликах от главной что то старое окажется??

Итог – при современном жестком фильтровании Яндексом всего подряд, страницы, содержащие дубли контента однозначно должны быть закрыты от индексации.

PS Нужно ваше мнение по поводу даты очередного апдейта PR.

Постовые (обмен постовыми):

Челябинский блогер написал о RBKmoney, новое слово в верификации пользователя.

Всё про партнерские программы на сайте ppmoney.ru